یک سالی است که جهان پس از عرضه ChatGPT با غول بزرگی به نام هوش مصنوعی و قابلیتهای فراوان آشنا شده و از همان ابتدای کار بسیاری بر خطرات متعدد و لزوم اقدام فوری مسئولان و شرکتهای ارائه دهنده تاکید کردهاند. با این حال دو رویکرد متفاوت را در نیم کره غربی نسبت به AI شاهد هستید، با اینکه اتحادیه اروپا بازهم در قانونگذاری پیشتاز جهان شده و به تعبیر ناظران سختترین قوانین را پیشنهاد کرده اما در ایالات متحده، منزلگاه بزرگترین شرکتهای هوش مصنوعی، شرایط متفاوت است. غولهای آمریکایی به تازگی تعهداتی داوطلبانه را به دولت آمریکا ارائه کردهاند.

رویکرد متفاوت اتحادیه اروپا و ایالات متحده نسبت به قانونگذاری و تنظیمگری شرکتهای تکنولوژی و دیگر فعالان صنعتی شاید یکی از عواملی است که در کنار موضوعاتی مثل نیروی کار ماهر، مالیات و دسترسی به منابع عظیم سرمایه باعث پیشتازی آمریکا به خصوصی در حوزه تکنولوژی شده است.

به طور کلی قانونگذاران قاره سبز سریعتر و سختگیرانهتر از همتایان آمریکایی خود عمل میکنند و قوانین جامع اتحادیه اروپا در حوزه حریم خصوصی و محافظت از داده یکی از مقرراتی است که تنها در یک مورد به جریمه ۱.۳ میلیارد دلاری برای فیسبوک منتهی شد.

اتحادیه اروپا همچنین کاملترین قانون هوش مصنوعی را نیز معرفی کرده و انتظار میرود این قانون که طرح اولیه آن سال ۲۰۲۱ پیشنهاد شد تا پایان سال ۲۰۲۳ به تصویب برسد.

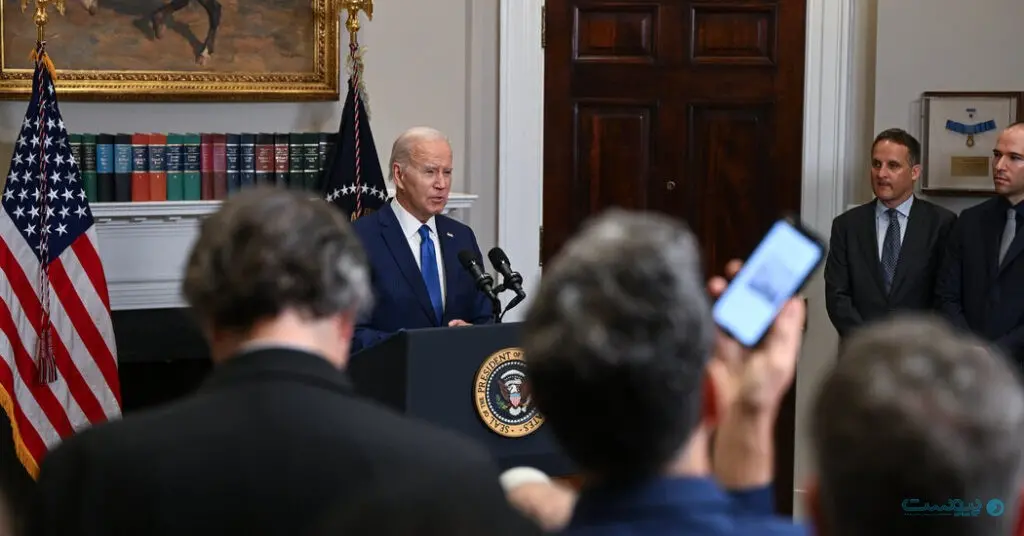

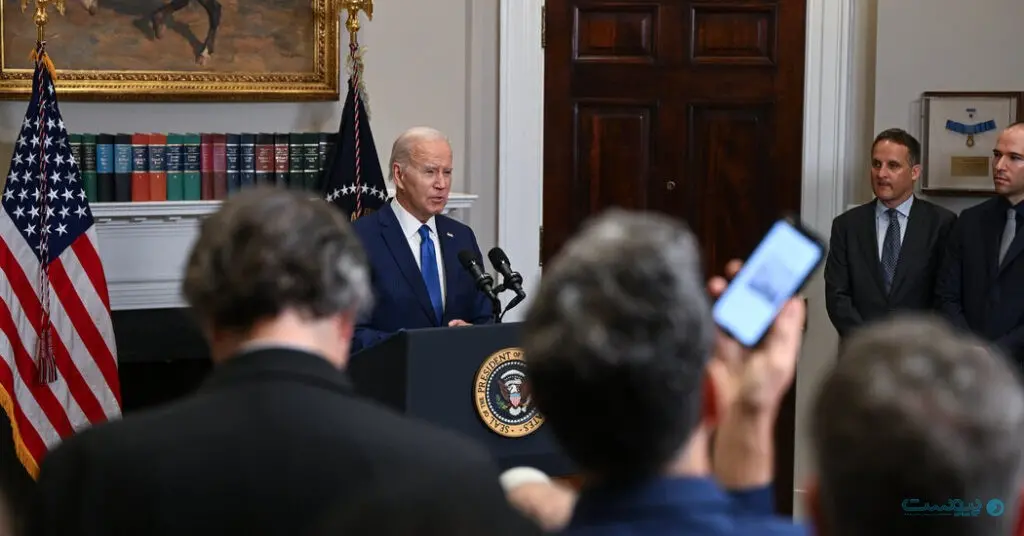

اما در آن سوی اقیانوس هنوز قانون جامع و فدرالی برای تنظیمگری هوش مصنوعی وجود ندارد و مقرراتی در حوزه حریم خصوصی، محافظت از داده و جلوگیری از تبعیض هرکدام به نحوی جوانب مختلف AI را زیر چتر خود میگیرند. در تازهترین تحولات شرکتهای تکنولوژی تعهداتی داوطلبانه را به کاخ سفید ارائه کردهاند و هدف جلوگیری از خطرات و تبعات منفی هوش مصنوعی است که در ادامه این تعهدات هشتگانه را بررسی میکنیم.

به روایت نیویورک تایمز، بزرگترین ارائه دهندگان محصولات هوش مصنوعی (آمازون، آنتروپیک، گوگل، اینفلکشن، متا، مایکروسافت و اوپنایآی)، متعهد شدهاند که:

۱. پیش از عرضه سیستمهای هوش مصنوعی آزمون امنیت داخلی و خارجی انجام دهند

تعهد آزمایش و آزمون امنیتی چیز جدیدی نیست و هرکدام از این شرکتها پیش از این هم به چنین اقداماتی متعهد شده بودند. از یک سو تعهد جدیدی ارائه نشده و افزون بر این وعده شرکتها مبهم است. جزئیات چندانی درمورد الزامات آزمون یا مسئول آن ارائه نشده است.

در بیانیهای که همراه با تعهدات منتشر شده کاخ سفید تنها تصریح میکند که «بخشی [از آزمایش مدلهای هوش مصنوعی] توسط متخصصان مستقل انجام میگیرد» و تمرکز این آزمونها بر خطراتی «همچون امنیت زیستی و امنیت سایبری است و تبعات گستردهتر اجتماعی را نیز شامل میشود.»

متعهد کردن شرکتها به این آزمونها و تشویق به شفافیت بیشتر در فرایند آزمایش نکته مثبتی است و مقامات دولتی و ارتش نیز برای ارزیابی برخی از انواع خطرات هوش مصنوعی-از جمله خطر استفاده از مدلهای هوش مصنوعی برای توسعه سلاحهای زیستی-گزینه مناسبتری هستند.

باید دید آیا صنعت هوش مصنوعی برروی بدنه مشخصی از آزمونهای امنیتی همچون «پاسخگویی خودمختار» (autonomous replication) که مرکز تحقیقاتی Alignment برروی مدلهای اوپنایآی و آنتروپیک به اجرا گذاشته به توافق میرسند. باید دید که آیا دولت آمریکا بودجه چنین آزمونهایی، که گاهی اوقات پرهزینه و نیازمند تخصص بالا هستند، را فراهم میکند. در حال حاضر تامین بودجه و نظارت بر بسیاری از آزمونها بر عهده شرکتها است که به وضوح با تضاد منافع همراه است.

۲. اطلاعات مربوط به مدیریت خطرات هوش مصنوعی را در تمام صنعت و با دولت، جامعه مدنی و آکادمیک به اشتراک بگذارند

تعهد دوم هم تا حدی مبهم است. بعضی از شرکتها پیشتر اطلاعاتی را درمورد مدلهای هوش مصنوعی خود-عمدتا به صورت مقالات آکادمیک یا پستهای وبلاگی-منتشر کردهاند. از جمله میتوان به اوپنایآی و آنتروپیک اشاره کرد که مستنداتی به نام «کارتهای سیستم» (System cards) را منتشر کردهاند و در آن به توصیف اقداماتشان برایر افزایش امنیت مدلها پرداختهاند.

اما در برخی موارد هم بعضی اطلاعات عرضه نشده و نگرانیهایی را در پی داشته است. اوپنایآی با عرضه مدل هوش مصنوعی GPT-4 به نوعی سنت شکنی کرد و اطلاعات مربوط به مقدار دادههای آموزشی یا گستره این مدل (پارامترهای آن) را مخفی نگه داشت. اوپنایآی گفته بود که به دلیل نگرانیهای رقابتی و ایمنی چنین اطلاعاتی را منتشر نکرده است.

آیا براساس تعهدات جدید، شرکتهای هوش مصنوعی ملزم به ارائه چنین اطلاعاتی هستند؟ اگر چنین کاری به سرعت رقابت را بیشتر کند چه میشود؟

به نظر هدف کاخ سفید بیشتر از اینکه انتشار پارامترهای هوش مصنوعی باشد، ترغیب شرکتها به تبادل اطلاعات با یکدیگر و بررسی خطرات مختلف از این طریق است.

اما چنین تعاملی هم خطراتی را به دنبال دارد. مثلا اگر تیم هوش مصنوعی گوگل در آزمایش پیش از عرضه خود جلوی استفاده از یک مدل جدید برای مهندسی سلاح زیستی را گرفته باشد آیا باید چنین اطلاعاتی را با خارج شرکت به اشتراک بگذارد؟ آیا چنین کاری طرح و ایده کافی را برای ساخت یک مدل در اختیار تبهکاران نمیگذارد؟

۳. در امنیت سایبری و مراقبتهای داخلی برای حفاظت از معیارها اختصاصی و منتشر نشده مدل سرمایهگذاری کنند

این تعهد از نگاه فعالان هوش مصنوعی روشنتر است و جای بحث کمتری دارد. «معیارهای مدل» (Model weights) به معنی دستورالعملهای ریاضی است که به مدلهای هوش مصنوعی امکان فعالیت میدهد. جاسوسان یا کسانی که مثلا به دنبال کپی کردن ChatGPT هستند برای سرقت همین معیارها تلاش میکنند و کنترل آنها به نفع شرکتها است.

پیشتر مشکلاتی در همین حوزه رخ داده که از جمله میتوان به نشت اطلاعات مدل هوش مصنوعی شرکت متا (LLaMA) اشاره کرد. این اطلاعات چند روز پس عرضه مدل در وبسایت 4chan و دیگر وبسایتها منتشر شد. با توجه به خطرات ناشی از انتشار چنین اطلاعاتی، چنین تعهدی منطقی به نظر میرسد.

۴. کشف و گزارش نقاط ضعف سیستمهای AI توسط شخص ثالث را تسهیل کنند

مفهوم این تعهد چندان روشن نیست. شرکتهای هوش مصنوعی پیش از این هم پس از عرضه محصولاتشان، آنهم به دلیل تلاش دیگران برای سو استفاده و دور زدن محدودیتها، نقاط ضعفی را شناسایی کردهاند.

با این حال این تعهد از شرکتها میخواهد تا «مکانیزم گزارش قدرتمندی» را ایجاد کنند تا بتوان نقاط ضعف را گزارش داد. مشخص نیست که منظور از این مکانیزم چیست و آیا منظور یک دکمه درون اپلیکیشنی همچون گزینه گزارش فیسبوک و توییتر است یا طرحهای پاداشی که در ازای کشف نقطه ضعف جایزه میدهند یا چیز دیگری.

۵. مکانیزمهای فنی قدرتمندی برای تضمین اطلاع رسانی درمورد محتوای تولیدی هوش مصنوعی از جمله یک سیستم واترمارک ارائه کنند

تا به اینجا شرکتهای هوش مصنوعی نتوانستند ابزاری را برای شناسایی دقیق محتوای تولید شده توسط هوش مصنوعی ایجاد کنند. دلایل فنی زیادی برای ضعف در این حوزه وجود دارد و درنتیجه کاربران میتوانند محتوای ساخته هوش مصنوعی را به عنوان اثر خودشان منتشر کنند.

مولدهای تصویر از جمله شرکت ادوبی و گوگل راهکاری را پیشنهاد کردهاند که با واترمارک یا نشانهگذاری محتوا، نقش هوش مصنوعی در تولید آن را مشخص میکند.

۶. درمورد توانمندیها، محدودیتها و موارد استفاده درست و نادرست گزارشهای عمومی ارائه کنند

تعهد ششم هم جای بحث بسیار دارد. چطور میتوان شرکتی را ملزم کرد تا درمورد توانمندیها و محدودیتهای سیستم خودش گزارش دقیق و بیطرف ارائه کند؟ این اطلاعات چه جزئیاتی را در بر میگیرد؟ و با توجه به موارد بسیاری که در آن توانمندی سیستم خود شرکت را نیز شگفت زده کرده چطور میتوان گزارشی روشن از آن ارائه کرد؟

۷. تحقیق درمورد خطرات اجتماعی سیستمهای هوش مصنوعی از جمله جلوگیری از تبعیض و سوگیری خطرناک و محافظت از حریم خصوصی را در اولویت قرار دهند

تعهد به «اولویت قراردادن تحقیقات» هیچ شفافیتی ندارد. نمیتوان مشخص کرد که چه سطحی از تحقیقات به معنای اولویت دهی درست است. با این حال بخشی از محققان که در رابطه با خطرات اخلاقی هوش مصنوعی و تبعیض نگران هستند احتمالا از این تعهد استقبال میکنند.

۸. سیستمهای هوش مصنوعی پیشرفتهای را برای رفع مهمترین چالشهای اجتماعی ساخته و به کار گیرند

کاخ سفید «پیشگیری از سرطان» و «جلوگیری از تغییر اقلیمی» را به دو چالش مهم اجتماعی مشخص کرده که شرکتهای هوش مصنوعی باید روی آن تمرکز کنند.

اما تحقیقات هوش مصنوعی را گاه با اهداف خاص به نتایج متفاوتی میرسند. بخشی از تکنولوژی آلفاگو از شرکت دیپمایند که برای بازی گو طراحی شده بود بعدا در پیشبینی ساختارهای سه بعدی پروتئین کاربرد پیدا کرد که اهمیت زیدی برای جامعه علمی داشت.

کوین روس، مقالهنویس حوزه تکنولوژی نیویورک تایمز، معتقد است که به طور کلی تعهد شرکتهای هوش مصنوعی به کاخ سفید ماهیت نمادین دارد. هیچ مکانیزیمی برای تضمین اجرای آنها در نظر گرفته نشده و بسیاری از تعهدات پیش از این هم در دستور کار شرکتها قرار داشته است.

با این حال از نگاه او گام اولیه خوبی است و موافقت با این تعهدات نشان میدهد که شرکتهای هوش مصنوعی از شکستهای پیشین تکنولوژی درس گرفتهاند.

باید دید که ایالات متحده، به عنوان میزبان بزرگترین شرکتهای هوش مصنوعی جهان در آینده چه تدابیر و قوانین رسمی را برای تنظیمگری این حوزه معرفی میکند.