درونزایی یا خویشآمیزی (Inbreeding) به روند زوال ژنتیکی یک جامعه در نتیجه آمیزش و تولید مثل با ژنتیک مشابه گفته میشود. این پدیده معمولا با بیان ژنهای نهفته، مشکلات زیادی را برای سلامتی انسان یا گونههای حیوانی ایجاد کرده و به ناهنجاریهایی متعددی منجر میشود. خویشآمیزی در مقیاس وسیع، مجموعه ژنهای یک جامعه را ناقص و گوناگونی آن را کمتر و کمتر میکند.

در دنیای هوش مصنوعی مولد هم چالش مشابهی را شاهد هستیم. چالشی که بازدهی سیستمهای هوش مصنوعی و گوناگونی فرهنگ بشری را تهدید میکند. از نگاه تکامل، نسل اول مدلهای بزرگ زبانی (LLMها) و دیگر سیستمهای هوش مصنوعی با «مجموعه ژنهای» مناسبی که برآمده از ساختههای بشری است آموزش دیدهاند؛ حجم زیادی محتوای متنی، صوتی و تصویری که به خوبی حساسیتهای فرهنگی انسان را نمایندگی میکنند.

اما رفته رفته و با افزایش حجم محتوایی که ساخته هوش مصنوعی است، سیستمهای جدید هوش مصنوعی ممکن است با دادههای ساختهی نسل قبلی خود آموزش ببیند. در غیاب ارتباط مستقیم با فرهنگ بشر، هوش مصنوعی محتوا را براساس برداشتی از دریچهای محدود یادگیری خود میسازد. همین محتوا به ژنهای در دسترس هوش مصنوعی تبدیل شده و با آلوده کردن آن، به خویش آمیزی در جهان هوش مصنوعی منتهی میشود.

افزون بر این، هرچه سیستمهای هوش مصنوعی مولد را بیشتر استفاده کنیم، مشکل خویشآمیزی هم تشدید میشود. تمام سیستمهایی که براساس فرهنگ انسان آموزش دیدهاند، مصنوعات جدید و تحریف شدهای از فرهنگ انسانی را تولید میکنند و به این ترتیب، نسل بعدی هوش مصنوعی براساس برداشت دسته دومی از فرهنگ انسان آموزش میبینید و این زنجیره با گذشت زمان ادامه پیدا میکند.

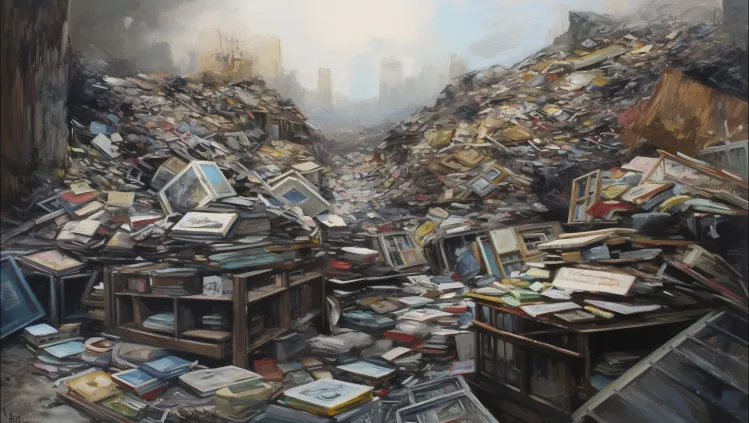

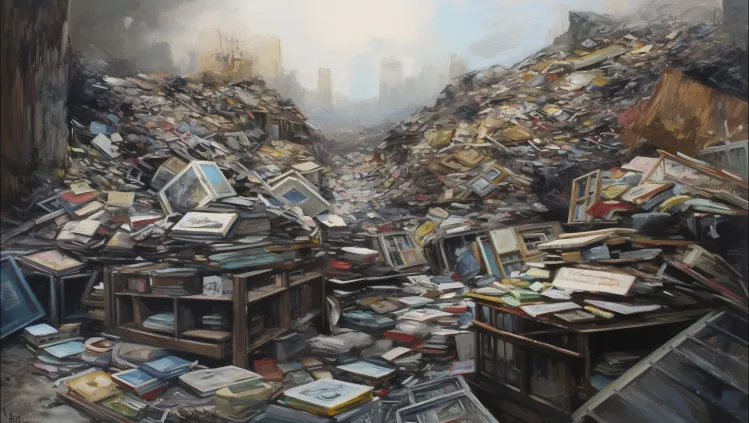

زوال سیستمهای هوش مصنوعی مولد و تحریف فرهنگ بشری

ونچربیت این چالش را «خویشآمیزی مولد» نامیده است و درمورد دو پیامد اصلی آن هشدار میدهد. اول اینکه هوش مصنوعی مولد ممکن به دلیل خویشآمیزی دیگر نماینده خوبی برای زبان، فرهنگ و مصنوعات انسانی به حساب نمیآید. ثانیاً، سیستمهای هوش مصنوعی خویشآمیز با تحریف فرهنگ انسانی «نقایصی» را وارد ژنهای فرهنگ ما میکنند. ژنهایی که نماد مناسبی از افکار عمومی ما نیستند.

در رابطه با اولین مساله، مطالعات جدید نشان میدهد که خویشآمیزی مولد ممکن است به زوال سیستمهای هوش مصنوعی و درنتیجه تولید مصنوعات بدتر و بدتری با گذشت زمان منجر شود. درست مثل اینکه از یک فتوکپی، فتوکپی دیگری بگیرید و الی آخر. گاه از این پدیده به عنوان «فروپاشی مدل» درنتیجهی «آلودگی دادهها» یاد میشود و براساس تحقیقات جدید، مدلهای بنیادی هوش مصنوعی بیش از آنچه تصور میشد در معرض این خطر قرار دارند. براساس یک مطالعه دیگر، افزایش سهم دادههای ساخته هوش مصنوعی در دادههای آموزشی، باعث میشود تا کیفیت خروجی این ابزارها دائماً بدتر و بدتر شود.

اما در رابطه با مساله دوم یا همان زوال فرهنگ بشری، خویشآمیزی مولد رفته رفته «نقایص» بزرگتری را وارد مصنوع میکند و در نهایت سیستمهای هوش مصنوعی امروزی بیشتر از انسانها بر نسل بعدی AI تاثیر میگذارند. همچنین از آنجایی که براساس حکم اخیر دادگاه در آمریکا، محتوای ساخته هوش مصنوعی شامل کپیرایت نمیشوند، استفاده از آنها نسبت به محتوای ساخته انسان توجیه اقتصادی بیشتری دارد.

درنتیجه شاید حق کپیرایت محتوای هنرمندان، نویسندگان، عکاسها و فیلمسازان باعث شود تا تاثیر آنها بر فرهنگ جمعی ما کاهش یافته و در عوض سهم هوش مصنوعی مولد از آن بیشتر شود.

تفکیک محتوای ساخته هوش مصنوعی از محتوای انسانی

یکی از راهحلهای مقابله با خویشآمیزی، استفاده از هوش مصنوعی برای تفکیک محتوای ساخته انسان از محتوای ماشینی است. بسیاری از محققان این گزینه را راهحلی ساده میپنداشتند، اما چنین کاری در عمل به شدت دشوار است.

برای مثال، شرکت اوپنایآی ابتدای سال جاری (۲۰۲۳) از یک ابزار «دستهبندی کننده هوش مصنوعی» با هدف تفکیک متون انسانی از متون ساخته AI رونمایی کرد. هدف از ارائه چنین ابزاری، شناسایی محتوای جعلی و جلوگیری از تقلب دانش آموزان بود. همین تکنولوژی را میتوان برای حذف محتوای ساخته هوش مصنوعی از دادههای آموزش و درنتیجه جلوگیری از خویشآمیزی استفاده کرد.

اما شرکت اوپنایآی در جولای ۲۰۲۳ اعلام کرد این ابزار به دلیل دقت پایین دیگر قابل دسترسی نیست و در حال حاضر «نمیتوان تمام متون ساخته هوش مصنوعی را با اطمینان کافی شناسایی کرد.»

نشانهگذاری محتوا

راهحل دیگر شرکتهای هوش مصنوعی، استفاده از راهکاری برای «نهاننگاری» (watermarking) دادهها است. این کار در موارد متعددی، از کمک به شناسایی مستندات جعلی و اطلاعات وارونه گرفته تا جلوگیری از تقلب دانشآموزان، کاربرد دارد.

اما متاسفانه نهاننگاری در بهترین حالت هم بازدهی چندانی نخواهد داشت زیرا محتوای متنی به راحتی قابل اصلاح است و با از میان رفتن نهاننگاری، مشکل خویشآمیزی به قوت خود باقی است. با این همه کاخ سفید بر ارائه راهحلهای نهاننگاری تاکید داشته و ماه گذشته هفت شرکت بزرگ هوش مصنوعی به «ساخت مکانیزمهای نیرومندی» از جمله نهاننگاری تعهد دادند تا کاربران بتوانند محتوای ساخته هوش مصنوعی را تشخیص دهند.

باید دید آیا این شرکتها میتوانند در عمل به تعهد خود عمل کنند و آیا این راهحلها به کاهش خویشآمیزی کمک خواهد کرد.

باید به جای پشت سر به روبرو نگاه کنیم

حتی در صورت رفع مشکل خویشآمیزی، هوش مصنوعی همچنان چالشی برای فرهنگ بشری است زیرا سیستمهای AI در واقع برای تقلید از سبک و محتوای گذشته طراحی شدهاند و به پشت سر نگاه میکنند.

این درست است که انسانهای هنرمند هم تحت تاثیر آثار قدیمی قرار دارند اما هر انسانی با توجه تجربیات و حساسیتهای بهخصوص خود، مسیر فرهنگی جدیدی را خلق میکند. سیستمهای هوش مصنوعی امروز، هیچ ایده جدیدی را به خروجی خود تزریق نمیکنند.

همین مساله در کنار تاثیر منفی خویشآمیزی، دست پنهانی است که «نقایص ژنتیکی» متعددی را وارد فرهنگ آینده ما خواهد کرد. فرهنگی که دیگر نماینده تفکر خلاق، احساسات و بینش بشری نیست.

اگر این مشکلات با راهکارهای فنی و سیاستگذاری برطرف نشوند، به زودی با جهانی مواجه میشویم که سیستمهای هوش مصنوعی بیشتر از انسان بر فرهنگ آن تاثیرگذارند.