لحظه «اوپنهایمر» هوش مصنوعی

یکی از بحثبرانگیزترین و در عین حال خطرناکترین زمینههای کاربرد هوش مصنوعی، حوزه نظامی و استفاده از سلاحهای خودکار و هوشمند به شمار میرود.

به گزارش مهر، انقلاب هوش مصنوعی به سرعت در حال تغییر چهره جهان است و تأثیرات عمیق آن در همه جوانب زندگی انسانی به وضوح مشاهده میشود. هوش مصنوعی از تحولات در صنعت و اقتصاد گرفته تا بهبود سیستمهای بهداشتی و آموزشی، به یکی از عوامل کلیدی در توسعه و پیشرفت جوامع مدرن تبدیل شده است. اما یکی از بحثبرانگیزترین و در عین حال خطرناکترین زمینههای کاربرد هوش مصنوعی، حوزه نظامی و استفاده از سلاحهای خودکار و هوشمند به شمار میرود. در حالی که هوش مصنوعی میتواند به شکلی قابل توجه کارایی و دقت عملیات نظامی را افزایش دهد، استفاده از آن در سلاحها و سیستمهای جنگی پرسشهای جدی اخلاقی و انسانی گوناگونی را در این زمینه مطرح میکند.

با گسترش روزافزون استفاده از این فناوری در میدانهای نبرد، نگرانیها درباره پیامدهای آن نیز افزایش یافته است. اکنون بیش از هر زمان دیگری، سوالاتی پیرامون ماهیت و اخلاق استفاده از هوش مصنوعی در جنگها مطرح میشود. آیا ماشینها باید تصمیمات حیاتی وابسته به مرگ و زندگی را بدون دخالت انسانها اتخاذ کنند؟ بهکارگیری گسترده سلاحهای هوش مصنوعی برای جامعه جهانی و امنیت بینالمللی چه تبعاتی در بر دارد؟

این مسائل تنها گوشهای از معضلاتی هستند که جهان امروز با آنها روبرو شده است. از یک سو، قدرتهای بزرگ جهانی و شرکتهای فناوری در حال رقابت برای توسعه و استفاده از هوش مصنوعی در سیستمهای نظامی هستند و از سوی دیگر، جامعه بینالمللی با چالشی بزرگ برای تنظیم و کنترل این فناوری روبرو است. مهر در این نوشتار کوتاه به بررسی ابعاد مختلف ادغام هوش مصنوعی در فعالیتهای نظامی پرداخته و تلاش میکند تا نگاهی جامع به پیامدهای اجتماعی، اخلاقی، حقوقی و سیاسی استفاده از هوش مصنوعی در جنگها ارائه دهد.

وضعیت گسترش استفاده از سلاحهای مجهز به هوش مصنوعی

استفاده از هوش مصنوعی در سلاحهای نظامی دیگر محدود به داستانها و آثار سینمایی علمی تخیلی نیست، بلکه به واقعیتی در میدان نبرد تبدیل شده است. به عنوان مثال، در طول سالهای اخیر، ارتش اوکراین با استفاده از پهپادهای مجهز به فناوری هوش مصنوعی و مواد منفجره یک مجموعه عملیات نظامی را علیه تأسیسات نفتی روسیه ترتیب داده است. همچنین، سیستمهای نظارتی مبتنی بر هوش مصنوعی آمریکا طیف گستردهای از اهداف خود را در سوریه و یمن شناسایی کرده و رژیم اشغالگر قدس نیز از سامانههای هدفگیری مبتنی بر هوش مصنوعی برای شناسایی و به شهادت رساندن هزاران شهروند فلسطینی در نوار غزه استفاده کرده است.

به عقیده کارشناسان و با گسترش استفاده از هوش مصنوعی در عملیات نظامی، تقاضا برای توسعه و استقرار این فناوری نیز به شدت افزایش یافته است. به عنوان مثال، پنتاگون قصد دارد برای شناسایی خودکار تهدیدات تا سال ۲۰۲۵ یک میلیارد دلار برای توسعه پهپادهای رزمی بدون سرنشین مبتنی بر هوش مصنوعی هزینه کند. این افزایش سرمایهگذاری باعث شده تا شرکتهای فناوری و دفاعی قراردادهای بزرگتری برای توسعه پروژههای تسلیحاتی مختلف به دست آورند.

به عنوان مثال، استارتاپ دفاعی «Anduril» طی روزهای اخیر موفق به جذب ۱.۵ میلیارد دلار سرمایه برای توسعه تسلیحات خودکار مبتنی بر هوش مصنوعی شده است. این سرمایهگذاری به «Anduril» کمک میکند تا از یک شرکت نوپا در صنعت دفاعی به یک پیمانکار جدی برای وزارت دفاع ایالات متحده تبدیل شود. این شرکت همچنین قصد دارد کارخانهای با نام «Arsenal-1» بسازد که به سبک کارخانههای پیشرفته شرکتهایی مانند تسلا و اپل طراحی شده و با استفاده از پلتفرم تولیدی مبتنی بر هوش مصنوعی، به تولید سریعتر پهپادها و تجهیزات نظامی کمک میکند.

متخصصان بر این باورند که این حرکت «Anduril» در پاسخ به نیاز فزاینده ارتش آمریکا به سیستمهای خودکار ارزانقیمت و قابلتولید در مقیاس بالا، به ویژه در مواجهه با چالشهایی مانند جنگ اوکراین و تهدیدات احتمالی از سوی چین صورت گرفته است. این شرکت امیدوار است با این روش نوآورانه، توانایی تولید تسلیحات مبتنی بر هوش مصنوعی را در آمریکا بهبود بخشد.

رقابت جهانی و افزایش نفوذ شرکتهای فناوری

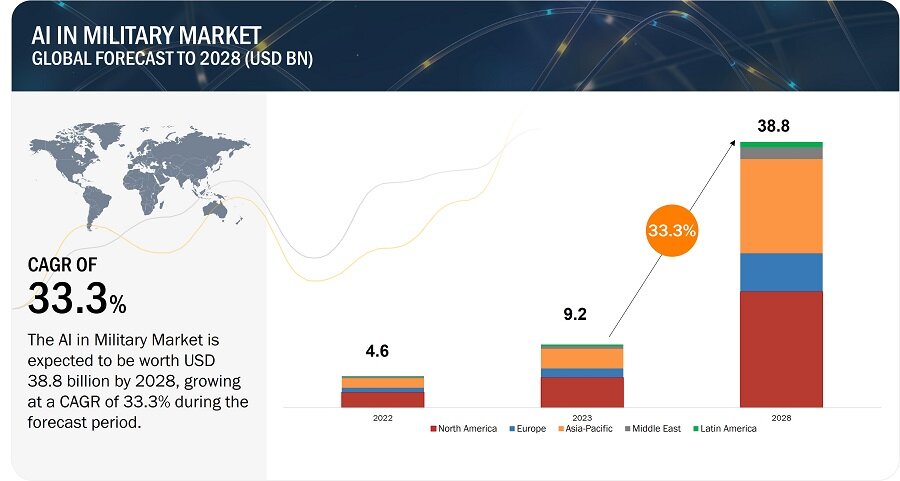

برآوردهای صورت گرفته حاکی از آن است که ارزش بازار هوش مصنوعی در صنایع نظامی با نرخ رشد مرکب سالانه ۳۳.۳ درصد از مبلغ ۹.۲ میلیارد دلار در سال ۲۰۲۳ به ۳۸.۸ میلیارد دلار در سال ۲۰۲۸ برسد. در این میان، ایالات متحده آمریکا و منطقه آسیا و اقیانوسیه بیشترین سهم را از این رشد بازار خواهند داشت. این روند مبین افزایش روزافزون اقبال دولتهای به استفاده از هوش مصنوعی در بخش نظامی خود است.

طیف گستردهای از شرکتهای فناوری نقش مهمی در توسعه سلاحهای مجهز به هوش مصنوعی ایفا میکنند. شرکتهایی مانند «Anduril» و «Palantir» از جمله پیشتازان در این زمینه هستند که قراردادهای بزرگی با دولتها و ارتشهای اقصی نقاط جهان منعقد کردهاند. بر اساس گزارشهای منتشر شده، این شرکتها با ارائه فناوریهای پیشرفته، به تسلیحاتیتر شدن ارتشها و دولتها کمک کرده و نقش کلیدی در شکلدهی به آینده جنگهای مدرن ایفا میکنند.

از سوی دیگر، با افزایش تقاضا برای سلاحهای خطرناک مبتنی بر هوش مصنوعی، غولهای فناوری از جمله گوگل و آمازون نیز تمایل بیشتری به همکاری با صنایع دفاعی نشان میدهند. بهعنوان مثال، شرکت فناوری گوگل اخیراً با امضای قراردادی با دولت و ارتش رژیم صهیونیستی، خدمات محاسبات ابری و قابلیتهای هوش مصنوعی را در اختیار اشغالگران قرار داده است. این همکاریها با وجود اعتصابات گسترده و اعتراضات داخلی در این شرکتها، نشاندهنده تغییر رویکرد این شرکتهای بزرگ نسبت به استفاده نظامی از هوش مصنوعی است.

چالشهای اخلاقی و حقوقی توسعه هوش مصنوعی نظامی

یکی از بزرگترین چالشهای مرتبط با استفاده از هوش مصنوعی در سلاحهای نظامی، مسائل اخلاقی است. مفهوم «وجود انسان در حلقه تصمیمگیری» که به معنای حفظ نظارت انسانی بر تصمیمات حیاتی ناظر بر مرگ و زندگی در جنگ است، مورد توافق عمومی همه کشورها و کارشناسان قرار دارد، اما چگونگی اجرای آن بهصورت عملی همچنان محل بحث است. برخی از متخصصان معتقدند که حفظ نظارت انسانی میتواند به حضور حداقلی و فشرده انسانی در فرایند منجر شود که در آن افراد تنها برای پذیرش مسئولیت اشتباهات سیستمهای هوش مصنوعی در موقعیتهای بحرانی حضور دارند.

از سوی دیگر، مسئله عدم شفافیت و پاسخگویی چالش بزرگ دیگری است که سیستمهای نظامی مبتنی بر هوش مصنوعی با آن مواجه هستند. استفاده از سیستمهای هوش مصنوعی در حوزه نظامی به دلیل طبیعت محرمانه و انحصاری این فناوریها با مشکلاتی از جمله عدم شفافیت و پاسخگویی همراه است. این مسئله باعث شده تا نظارت عمومی و اطمینان از عملکرد صحیح و اخلاقی این سیستمها از سوی ناظران و جامعه مدنی بسیار دشوار شود. بهعنوان مثال، گزارشی درباره عملیات نظامی اشغالگران صهیونیست نشان میدهد که نظامیان این رژیم بهرغم آگاهی از ضریب خطای ۱۰ درصدی سیستمهای مبتنی بر هوش مصنوعی در شناسایی اهداف، همچنان از آن برای کشتار شهروندان فلسطینی استفاده میکنند.

چالشهای حقوقی و بینالمللی توسعه هوش مصنوعی نظامی

همگام با گسترش استفاده از سلاحهای مجهز به هوش مصنوعی، تلاشهای بینالمللی برای تنظیم مقررات در این زمینه نیز افزایش یافته است. به عنوان مثال، در جریان برگزاری کنفرانس سیستمهای تسلیحاتی خودکار وین (The Vienna Conference on Autonomous Weapons Systems) در آوریل سال ۲۰۲۳، سازمانهای بینالمللی و دیپلماتهایی از ۱۴۳ کشور گرد هم آمدند تا درباره تنظیم استفاده از هوش مصنوعی و سلاحهای خودکار در جنگ بحث و تبادل نظر کنند؛ روندی که تا به امروز همچنان ادامه دارد. به عقیده کارشناسان، این تلاشها نشاندهنده نگرانیهای جهانی نسبت به تأثیرات بالقوه مخرب این فناوریهای نوین بر صلح و امنیت بینالمللی است.

از سوی دیگر با وجود حمایت گسترده بینالمللی برای تنظیم مقررات بینالمللی مربوط به سلاحهای خودکار، کشورهای بزرگ تولیدکننده و استفادهکننده از این فناوریها مانند آمریکا، رژیم صهیونیستی، روسیه، چین و کره جنوبی بهطور کلی مخالف وضع قوانین الزامآور جدید در این زمینه هستند. این مخالفتها نشاندهنده چالشهای جدی در دستیابی به توافقات بینالمللی برای کنترل و نظارت بر استفاده از هوش مصنوعی در جنگ به شمار میرود.

پیامدهای اجتماعی و داخلی توسعه هوش مصنوعی نظامی

تبعات توسعه تسلیحات خودکار تنها به مسائل اخلاقی و حقوقی محدود نمیشود. با گسترش استفاده از سلاحهای مبتنی بر هوش مصنوعی در جنگها، نگرانیهایی درباره تأثیرات این فناوریها بر جامعه و نیروهای پلیس داخلی کشورها نیز مطرح شده است. بسیاری از فعالان مدنی جهان به این امر معترض هستند. برخی متخصصان معتقدند که استفاده از این فناوریها در جنگها میتواند به تدریج به حوزههای دیگری مانند نظارتهای داخلی و کنترل مرزها نیز سرایت کند؛ امری که میتواند تهدیدی جدی برای آزادیهای اجتماعی و حقوق مدنی باشد.

همچنین با گسترش استفاده از سلاحهای خودکار مبتنی بر هوش مصنوعی، مفهوم جنگ و صلح نیز در حال تغییر است. اگرچه استفاده از این فناوریها میتواند به تغییر استراتژیهای نظامی و کاهش نیاز به نیروی انسانی در جنگها منجر شود؛ اما این تغییرات همچنین میتواند به تشدید تنشهای بینالمللی و افزایش احتمال درگیریهای نظامی منجر شود و خسارات به جانی و مالی به بخشهای غیرنظامی را به شکل محسوسی افزایش دهد.

سخن پایانی

شکی نیست که استفاده از هوش مصنوعی در عملیات نظامی به سرعت در حال گسترش است و تأثیرات گسترده و عمیقی بر جامعه، اقتصاد و سیاست جهانی خواهد داشت. این فناوری با تمام پتانسیلها و نوآوریهای خود، مسائل جدی و پیچیدهای را در زمینه اخلاق، حقوق بینالملل و امنیت به وجود آورده است. از یک سو، هوش مصنوعی میتواند با افزایش دقت و کارایی عملیات نظامی، به بهبود استراتژیهای دفاعی کشورها کمک کند. اما از سوی دیگر، به کارگیری این فناوری در جنگها و عملیات نظامی بدون نظارت و کنترل مناسب، منجر به تشدید درگیریها، افزایش خشونت و نقض حقوق بشر میشود.

با توجه به این تحولات، ضرورت دارد که جامعه بینالمللی به جای تأخیر و واکنش پس از وقوع بحرانها، از هماکنون برای تنظیم مقررات و ایجاد چارچوبهای مناسب برای مواجهه با این چالش اقدام کند. تجربیات گذشته نشان میدهد زمانی که یک فناوری بهطور گسترده مورد استفاده قرار گیرد، کنترل و مهار آن بسیار دشوارتر از مراحل ابتدایی میشود. بنابراین، پیشگیری و مدیریت هوشمندانه این تحولات، میتواند از بروز بحرانهای جدی در آینده جلوگیری کند.

بنابراین میتوان نتیجه گرفت که استفاده از هوش مصنوعی در سلاحهای نظامی همانند یک شمشیر دو لبه عمل میکند. این فناوری میتواند هم به بهبود امنیت و هم به افزایش خطرات منجر گردد. از همین روی کاربردهای نظامی هوش مصنوعی نیازمند نظارت گسترده، تنظیم مقررات دقیق و مسئولیتپذیری از سوی تمامی بازیگران بینالمللی است.