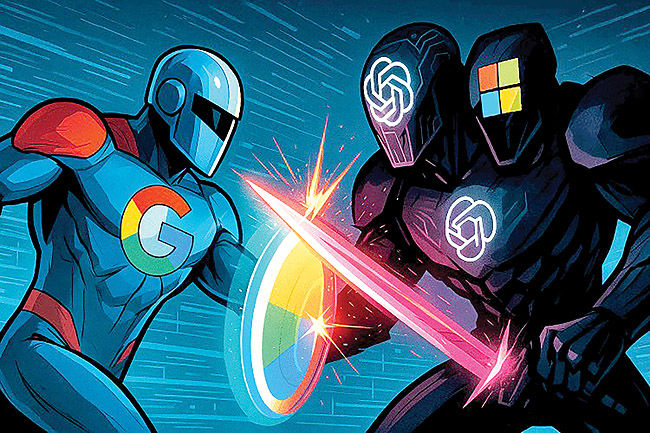

هزینههای پردازشی؛ تعیینکننده برنده نبرد هوش مصنوعی

گویا روند بیوقفه و شتابان نوآوری در هوش مصنوعی مولد قصد توقف ندارد. در همین چند هفته اخیر شرکت اوپنایآی از مدلهای استدلال قدرتمند o۳ و o۴-mini در کنار سری GPT-۴.۱ پرده برداشت. گوگل نیز با معرفی Gemini۲.۵Flash به این تحرکات پاسخ داد و این شرکت همزمان در حال ارتقا و بهبود مدل پیشتاز خود Gemini ۲.۵ Pro است که اندکی پیش از آن روانه بازار شده بود.

برای مدیران فنی سازمانها که در این فضای گیجکننده و پر از تغییر در حال تصمیمگیری هستند، انتخاب پلتفرم هوش مصنوعی مناسب نیازمند نگاهی عمیقتر و فراتر از بررسی سریع و گذرای معیارهای ارزیابی مدلها است. اگرچه این روزها مقایسههای مدل به مدل سرخط خبرها را به خود اختصاص میدهند، اما تصمیمگیری برای مدیران فنی ابعاد بسیار گستردهتری دارد. انتخاب یک پلتفرم هوش مصنوعی در واقع پذیرش تعهد به یک اکوسیستم است که تمام جنبهها را تحت تاثیر قرار میدهد؛ از هزینههای اساسی محاسبات و راهبرد توسعه عاملهای هوشمند گرفته تا میزان اطمینانپذیری مدل و نحوه ادغام آن در ساختار سازمانی.

البته شاید شاخصترین وجه تمایزی که اکنون چندان آشکار نیست، ولی در بلندمدت تاثیرات عمیقی خواهد داشت به اقتصاد سختافزاری برمیگردد که این غولهای هوش مصنوعی را به کار میاندازد. گوگل به کمک استفاده از تراشههای اختصاصی خود از یک برتری بسیار بزرگ در هزینهها برخوردار است. این امر احتمالا به گوگل این امکان را میدهد تا پردازشهای مربوط به هوش مصنوعی خود را با کسری از هزینهای انجام دهد که اوپنایآی به دلیل وابستگی به پردازندههای گرافیکی انویدیا متحمل میشود که هم بر بازار مسلط هستند و هم سود زیادی نصیب انویدیا میکنند. در اینجا قرار است پا را فراتر از مقایسه معیارها بگذاریم و به سنجش اکوسیستمهای هوش مصنوعی گوگل و اوپنایآی-مایکروسافت در زمینه عوامل کلیدی بپردازیم که سازمانها امروزه باید به آنها توجه کنند؛ مواردی از قبیل اختلاف فاحش در هزینههای محاسباتی، راهبردهای متفاوت برای توسعه عاملهای هوش مصنوعی، موازنههای حیاتی در تواناییها و اعتمادپذیری مدلها و واقعیتهای مربوط به انطباق سازمانی و نحوه توزیع. در واقع این تحلیل بر مباحثی شکل گرفته است که به تازگی یک توسعهدهنده هوش مصنوعی پیرامون این تحولات بنیادین مطرح کرد.

صرفه اقتصادی در قدرت پردازش

بزرگترین و در عین حال نادیده گرفتهشدهترین مزیت گوگل در این رقابت، همان برگ برنده پنهان آن است؛ یعنی یک دهه سرمایهگذاری در واحدهای پردازش اختصاصی. در سوی دیگر، اوپنایآی و کل اکوسیستم هوش مصنوعی بهشدت به پردازندههای گرافیکی قدرتمند، اما پرهزینه انویدیا مانند H۱۰۰ و A۱۰۰ وابسته هستند. این در حالی است که گوگل برای سنگینترین بار کاری هوش مصنوعی خود تراشههای سفارشی TPU را طراحی کرده و به کار میگیرد، مانند نسل جدید Ironwood که اخیرا معرفی شده است و گوگل برای آموزش و ارائه مدلهای Gemini از آن استفاده میکند. اما اهمیت این موضوع در آنجاست که این امر یک تفاوت هزینه بسیار فاحش را رقم میزند. حاشیه سود ناخالص پردازندههای گرافیکی انویدیا سرسامآور است. تحلیلگران تخمین میزنند که این حاشیه برای تراشههای ویژه مراکز داده مانند H۱۰۰ و پردازندههای گرافیکی B۱۰۰ که به زودی عرضه میشوند، حدود ۸۰ درصد باشد. این یعنی اوپنایآی از طریق Microsoft Azure برای توان پردازشی خود مبلغ هنگفتی را به عنوان هزینه انویدیا میپردازد. در مقابل گوگل با تولید داخلی تراشههای TPU عملا این سود مضاعف را دور میزند.

گزارشها نشان میدهد که هزینه تولید هر واحد پردازنده گرافیکی برای انویدیا بین ۳تا۵ هزار دلار است، اما شرکتهای بزرگ ارائهدهنده خدمات ابری مانند مایکروسافت -سهامدار اوپنایآی- برای خرید عمده هر واحد مبلغی بین ۲۰ هزار تا بیش از ۳۵ هزار دلار پرداخت میکنند. گفتوگوها و تحلیلهای فعالان صنعت حاکی از آن است که گوگل احتمالا توان پردازشی مورد نیاز برای هوش مصنوعی خود را با حدود ۲۰درصد هزینهای که خریداران پردازندههای گرافیکی پیشرفته انویدیا متحمل میشوند، تامین میکند. اگرچه ارقام دقیق محرمانه هستند، اما معنای ضمنی آن این است که گوگل در سطح سختافزار به ازای هر واحد محاسباتی از یک مزیت بهرهوری هزینه ۴ تا ۶ برابری برخوردار است. این برتری ساختاری در قیمتگذاری رابطهای برنامهنویسی (API) هم خود را نشان میدهد. با نگاهی به مدلهای پیشتاز، مدل o۳ اوپنایآی برای توکنهای ورودی حدود ۸ برابر و برای توکنهای خروجی ۴ برابر گرانتر از Gemini ۲.۵ Pro گوگل است. این اختلاف قیمت فقط یک بحث نظری نیست، بلکه پیامدهای راهبردی عمیقی دارد. گوگل به احتمال زیاد میتواند قیمتهای پایینتری را حفظ کند و هوشمندی بیشتری در ازای هر دلار ارائه دهد. این امر به سازمانها امکان میدهد تا هزینه کل مالکیت بلندمدت قابل پیشبینیتری داشته باشند؛ اقدامی که گوگل در حال حاضر عملا در حال انجام آن است.

در مقابل هزینههای اوپنایآی به شکلی جداییناپذیر به قدرت قیمتگذاری انویدیا و مفاد قراردادش با Azure (آژور) وابسته است. بنا به برخی گزارشها، تخمین زده میشود که هزینههای مربوط به قدرت پردازشی و محاسباتی حدود ۵۵ تا ۶۰ درصد از کل ۹ میلیارد دلار هزینههای جاری اوپنایآی در سال ۲۰۲۴ را تشکیل داده است. همچنین پیشبینی میشود که با بزرگتر شدن و گسترش فعالیتهای اوپنایآی این سهم در سال ۲۰۲۵ حتی از ۸۰ درصد هم بیشتر شود. با وجود این درآمد اوپنایآی با یک رشد بسیار چشمگیر روبهرو خواهد بود؛ طبق پیشبینیهای داخلی که منتشر شده احتمالا این رقم تا سال ۲۰۲۹ به ۱۲۵ میلیارد دلار خواهد رسید. با این حال مدیریت همین هزینههای پردازشی همچنان یک چالش بسیار مهم برای این شرکت محسوب میشود و همین موضوع آنها را بهشدت به دنبال ساخت تراشههای اختصاصی خود سوق داده است.

اکوسیستم باز در برابر یکپارچه

این دو غول فناوری جدا از سختافزار، راهبردهای کاملا متفاوتی را برای ساخت و به کارگیری عاملهای هوش مصنوعی دنبال میکنند؛ راهبردهایی که قرار است جریانهای کاری شرکتها را خودکار کنند. گوگل به وضوح در حال پیشبرد ایده سازگاری متقابل و یک اکوسیستم بازتر است. در رویداد Cloud Next که دو هفته پیش برگزار شد، این شرکت از پروتکل Agent-to-Agent رونمایی کرد؛ پروتکلی که طراحی شده تا عاملهایی که روی پلتفرمهای گوناگون ساخته شدهاند بتوانند با یکدیگر ارتباط برقرار کنند. در کنار این کیت توسعه عامل (ADK) و مرکز Agentspace برای کشف و مدیریت این عاملها نیز معرفی شدند. با این حال پذیرش A۲A با چالشهایی روبهرو است؛ بازیگران کلیدی مانند Anthropic هنوز به آن ملحق نشدهاند. خبرنگار VentureBeat برای پیگیری این موضوع با Anthropic تماس گرفت، اما آنها از اظهارنظر خودداری کردند. هدف گوگل روشن است؛ ایجاد یک بازار چندفروشندهای برای عاملهای هوشمند که احتمالا در Agent Garden خود یا از طریق یک Agent App Store که شایعاتی هم درباره آن وجود دارد، میزبانی خواهد شد.

در مقابل به نظر میرسد تمرکز اوپنایآی بر ساخت عاملهای قدرتمند و ابزارمحور است که به شکلی تنگاتنگ با زیرساختهای خود یکپارچه شدهاند. مدل جدید o۳ نمونه بارز این رویکرد است که قادر است صدها بار ابزارهای مختلف را در یک زنجیره استدلال واحد فراخوانی کند. توسعهدهندگان از APIهای Responses و SDK Agents به همراه ابزارهایی مانند Codex CLI جدید برای ساخت عاملهای هوشمند پیچیدهای استفاده میکنند که در محدوده امنیتی اوپنایآی- آژور عمل میکنند. اگرچه چارچوبهایی مانند Autogen مایکروسافت انعطافپذیری نسبی ارائه میدهند، اما به نظر میرسد استراتژی اصلی اوپنایآی کمتر بر ارتباطات بین پلتفرمی و بیشتر بر به حداکثر رساندن تواناییهای عامل به صورت عمودی در محیط تحت کنترل خود متمرکز است.

نکته کلیدی برای شرکتها این است که کسبوکارهایی که به دنبال انعطافپذیری بیشتری هستند و میخواهند عاملهای مختلف هوش مصنوعی از ارائهدهندگان گوناگون را با یکدیگر ترکیب کنند (مثلا یک عامل از Salesforce را به Vertex AI متصل کنند) احتمالا از رویکرد باز گوگل استقبال خواهند کرد. در مقابل شرکتهایی که سرمایهگذاری سنگینی در اکوسیستم آژور- مایکروسافت داشتهاند یا ترجیح میدهند از یک مجموعه یکپارچه و پرفشار از نمایندهها استفاده کنند، احتمالا اوپنایآی را گزینه بهتری میبینند.

عملکرد و نقاط ضعف کلیدی

گردش بیامان انتشار مدلهای جدید هوش مصنوعی به این معناست که برتری در این عرصه عمری کوتاه دارد. در حال حاضر اگرچه مدل o۳ اوپنایآی در برخی آزمونهای برنامهنویسی مانند SWE-Bench Verified و Aider اندکی از Gemini ۲.۵ Pro گوگل پیشی میگیرد، اما Gemini ۲.۵ Pro در آزمونهای دیگری نظیر GPQA و AIME همسطح آن است یا حتی بهتر عمل میکند. همچنین Gemini ۲.۵ Pro در صدر جدول ردهبندی کلی مدلهای زبانی بزرگ (LLM) در LLM Arena Leaderboard قرار دارد. با این حال برای بسیاری از کاربردهای سازمانی این مدلها در تواناییهای اساسی به یک برابری تقریبی رسیدهاند. تفاوت اصلی این مدلها در ویژگیهای متمایز آنها نهفته است:

گستره متن در مقابل عمق استدلال:

Gemini ۲.۵ Pro با پنجره متنی عظیم یک میلیون توکنی(و برنامهریزی برای ۲ میلیون)، برای پردازش حجم وسیعی از کدها یا مجموعههای اسناد بسیار مناسب است. در مقابل o۳ اوپنایآی پنجرهای ۲۰۰ هزار توکنی ارائه میدهد، اما بر استدلال عمیق و با کمک ابزار در یک تعامل واحد که به لطف رویکرد یادگیری تقویتی آن امکانپذیر شده، تاکید دارد.

اعتمادپذیری در مقابل ریسک: این جنبه به یک عامل تمایز بسیار مهم تبدیل شده است. در حالی که o۳ توانایی استدلال چشمگیری از خود نشان میدهد، کارت مدل خود اوپنایآی برای o۳ فاش کرد که میزان توهمزایی آن بهطور قابل توجهی بیشتر است (دو برابر نرخ o۱ در آزمون PersonQA) . برخی تحلیلها نشان میدهند که این مساله ممکن است ناشی از سازوکارهای پیچیده استدلال و استفاده از ابزار در آن باشد. Gemini ۲.۵ Pro اگرچه شاید گاهی در ساختار خروجی خود کمتر نوآورانه به نظر برسد، اما اغلب توسط کاربران به عنوان قابل اعتمادتر و قابل پیشبینیتر برای وظایف سازمانی توصیف میشود. شرکتها باید تواناییهای پیشرفته o۳ را در مقابل این افزایش مستند در خطر توهمزایی بسنجند.

نکته کلیدی برای سازمانها: بهترین مدل به نوع وظیفه بستگی دارد. Gemini ۲.۵ Pro برای تحلیل حجم وسیعی از متن یا اولویت دادن به خروجیهای قابل پیشبینی برتری دارد. برای وظایفی که نیازمند عمیقترین سطح استدلال با استفاده از چند ابزار هستند و در آنها میتوان خطر توهمزایی را با دقت مدیریت کرد، o۳ یک رقیب قدرتمند به شمار میرود. کارشناسان تاکید دارند که آزمایش دقیق در چارچوب کاربردهای سازمانی خاص، امری ضروری است.

عمق یکپارچگی در مقابل گستردگی نفوذ در بازار

در نهایت میزان استقبال از یک پلتفرم اغلب به این بستگی دارد که چقدر ساده میتواند در زیرساختها و روالهای کاری فعلی یک سازمان جای بگیرد. نقطه قوت گوگل یکپارچگی عمیق برای مشتریانی است که همین حالا از Google Cloud و Workspace استفاده میکنند. مدلهای Gemini، Vertex AI، Agentspace و ابزارهایی مانند BigQuery طوری طراحی شدهاند که به شکلی بینقص با یکدیگر کار کنند و یک مرکز کنترل یکپارچه، مدیریت داده منسجم و بهطور بالقوه رسیدن سریعتر به ارزش را برای شرکتهایی که پیش از این در اکوسیستم گوگل سرمایهگذاری کردهاند، فراهم میکنند. گوگل بهطور فعال در حال جذب شرکتهای بزرگ است و نمونههای استقرار موفق خود را در شرکتهایی مانند Wendy’s، Wayfair و Wells Fargo به نمایش میگذارد. در مقابل اوپنایآی از طریق مایکروسافت، از گستردگی و دسترسی بینظیری در بازار برخوردار است؛ پایگاه کاربری وسیع چتجیپیتی حدود ۸۰۰ میلیون کاربر فعال ماهانه باعث ایجاد آشنایی گستردهای شده است.

مهمتر از آن مایکروسافت به شکلی فعالانه در حال ادغام مدلهای اوپنایآی از جمله آخرین سری o در Microsoft ۳۶۵ Copilot و سرویسهای آژور خود است. این امر قابلیتهای قدرتمند هوش مصنوعی را به شکلی آسان و در دسترس برای صدها میلیون کاربر سازمانی قرار میدهد، اغلب در همان ابزارهایی که آنها به صورت روزانه از آنها استفاده میکنند. برای سازمانهایی که همین حالا بر مبنای آژور و مایکروسافت ۳۶۵ استانداردسازی شدهاند، بهکارگیری اوپنایآی میتواند یک گام طبیعیتر به نظر برسد. علاوه بر این، استفاده گسترده توسعهدهندگان از APIهای اوپنایآی به این معناست که بسیاری از درخواستها و روالهای کاری سازمانی، پیش از این برای مدلهای اوپنایآی بهینه شدهاند.

در اینجا تصمیم راهبردی و انتخاب نهایی اغلب به روابط فعلی با تامینکنندگان بستگی دارد. گوگل یک فرآیند جذاب و یکپارچه را برای مشتریان فعلی خود ارائه میدهد. در مقابل اوپنایآی با تکیه بر موتور توزیع قدرتمند مایکروسافت دسترسی گسترده و پذیرش بالقوه آسانتری را برای تعداد زیادی از شرکتهایی که محوریت آنها مایکروسافت است، فراهم میکند.

انتخابی با جوانب مثبت و منفی برای سازمانها

نبرد بین گوگل و اوپنایآی در عرصه پلتفرمهای هوش مصنوعی مولد مدتهاست که از مقایسههای ساده مدلها فراتر رفته است. در حالی که هر دو قابلیتهای پیشرفتهای را ارائه میدهند، اما نمایانگر رویکردهای استراتژیک متفاوت و مزایا و معایب منحصربهفردی برای سازمانها هستند. شرکتها باید رویکردهای گوناگون به چارچوبهای عامل هوشمند، مصالحههای ظریف بین قابلیتهای مدل مانند طول بافت متن در مقابل استدلال پیشرفته و ملاحظات عملی مربوط به یکپارچگی سازمانی و گستردگی توزیع را به دقت بسنجند. با این حال آنچه بر همه این عوامل سایه افکنده، واقعیت آشکار هزینههای محاسباتی است که احتمالا به عنوان مهمترین و تعیینکنندهترین عامل تمایز بلندمدت خودنمایی میکند؛ بهویژه اگر اوپنایآی نتواند به سرعت آن را مدیریت کند. استراتژی یکپارچه TPU گوگل که به آن امکان میدهد تا بهطور بالقوه از مالیات حدودا ۸۰ درصدی انویدیا نهفته در قیمتگذاری GPUها که بار سنگینی بر دوش اوپنایآی گذاشته است، عبور کند و این یک مزیت اقتصادی بنیادین و احتمالا تغییری اساسی در بازی به شمار میرود.

این فراتر از یک اختلاف قیمت ساده است، چون بر تمام جنبهها اثر میگذارد؛ از قیمت مناسبتر APIها و قابلیت پیشبینی بلندمدت هزینه کل مالکیت (TCO) گرفته تا مقیاسپذیری بیحد و حصر پیادهسازیهای هوش مصنوعی. با رشد نمایی حجم کار هوش مصنوعی، پلتفرمی که از یک موتور اقتصادی پایدارتر بهره میبرد و موتوری که با بهرهوری هزینه سختافزار تغذیه میشود، یک برتری استراتژیک قدرتمند را در اختیار خواهد داشت. گوگل از این مزیت بهره میبرد و همزمان دیدگاه باز خود را در مورد قابلیت تعامل عاملهای هوشمند نیز ترویج میکند. در مقابل اوپنایآی که از مقیاس بالای مایکروسافت پشتیبانی میشود با مدلهای عمیقا یکپارچه و توانمند در استفاده از ابزارها و دسترسی بینظیر به بازار به مقابله میپردازد، هر چند هنوز ابهاماتی در مورد ساختار هزینهها و میزان اطمینانپذیری مدلهایش وجود دارد.